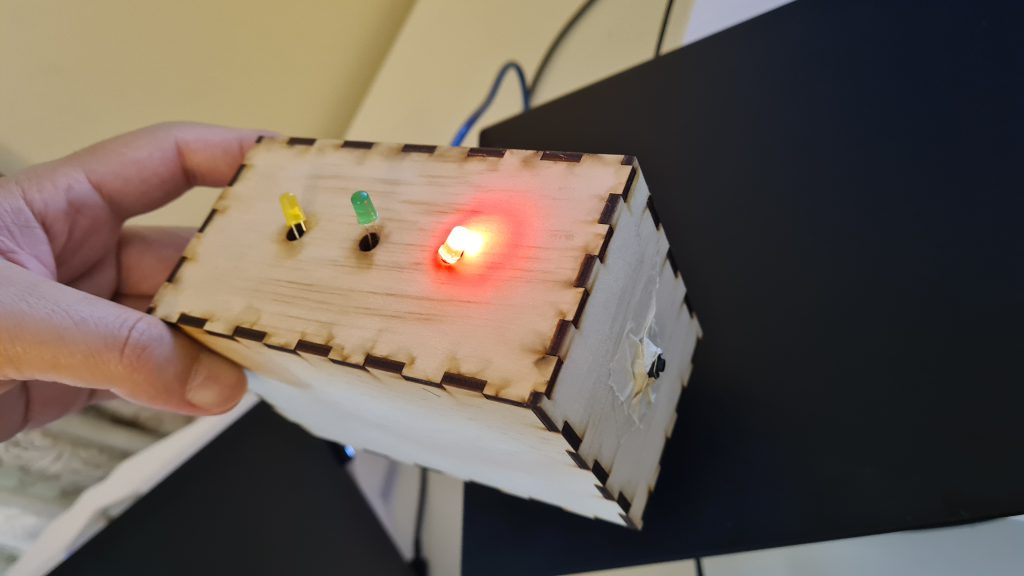

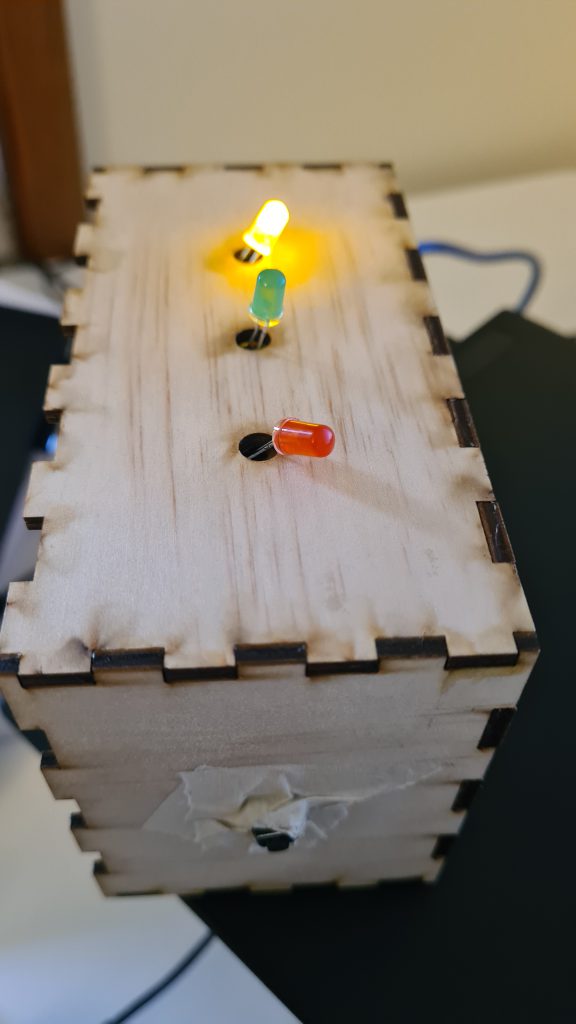

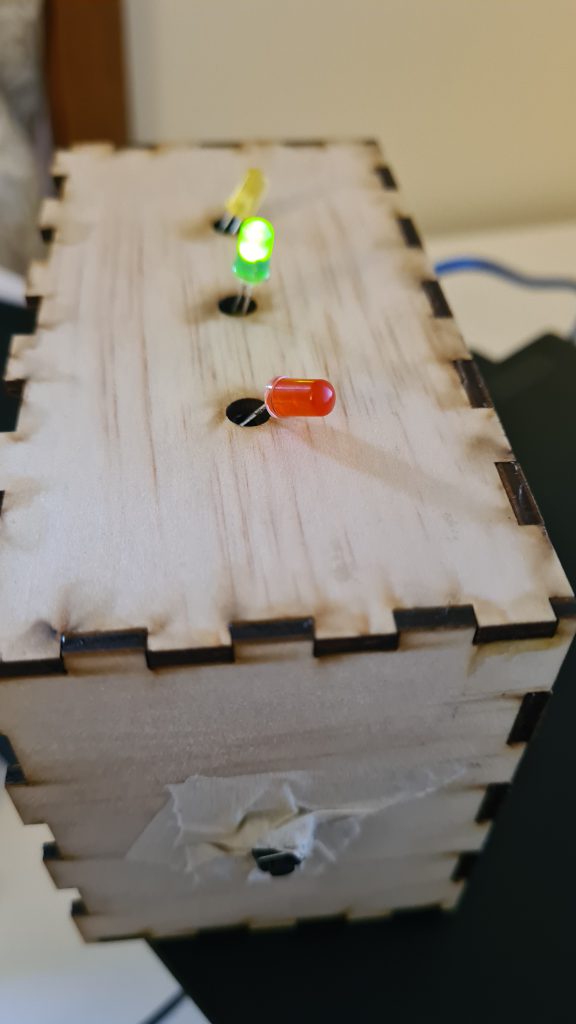

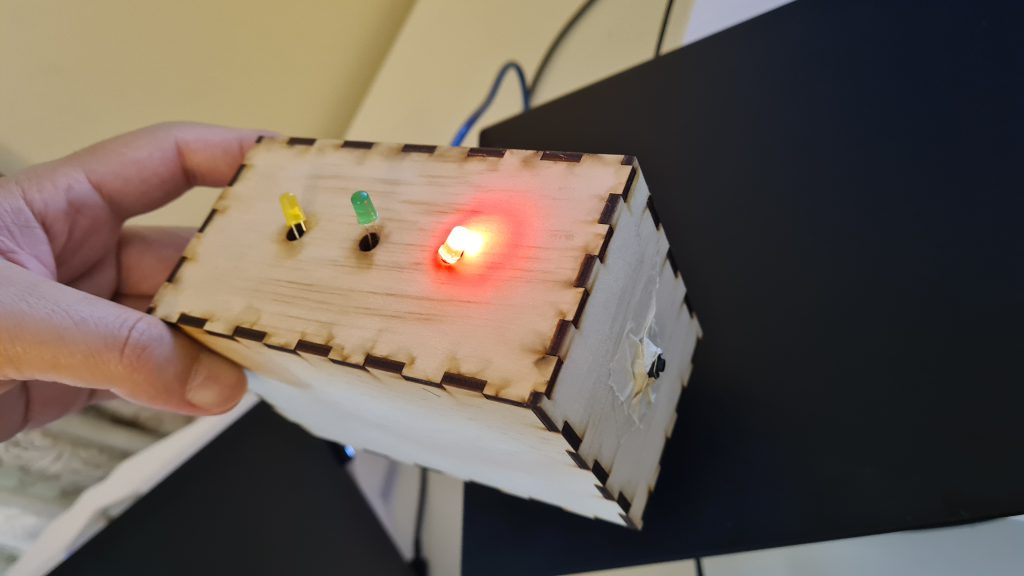

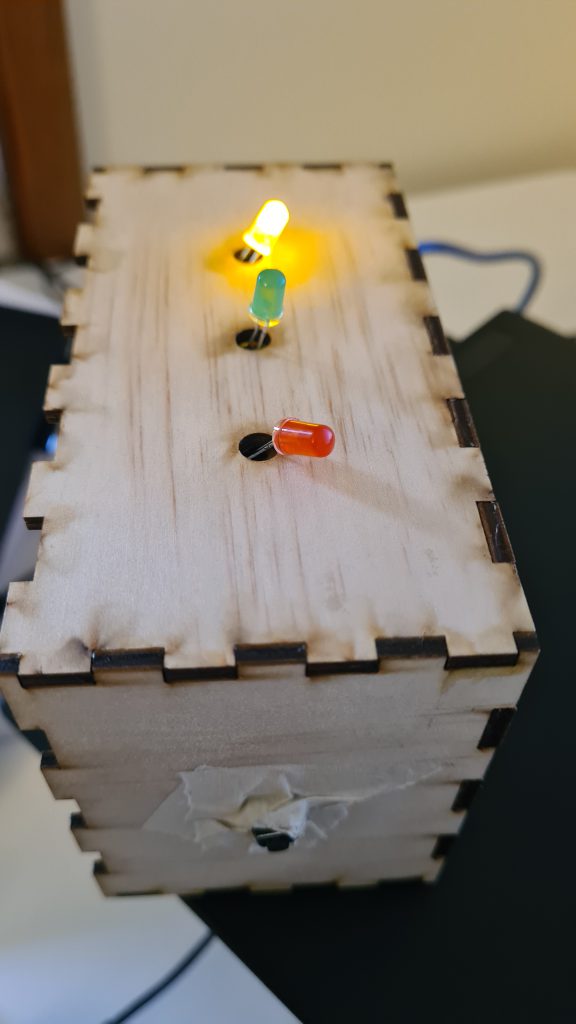

儿子12岁,初一年末设计是用的Arduino Uno R1 加上C++ ,设计了这个红黄绿灯交替开关的装置。

布线有点乱,但是比我强。因为我上初一的时候,只会用GW-BASIC输出一些用ASCII组合的图形。

儿子12岁,初一年末设计是用的Arduino Uno R1 加上C++ ,设计了这个红黄绿灯交替开关的装置。

布线有点乱,但是比我强。因为我上初一的时候,只会用GW-BASIC输出一些用ASCII组合的图形。

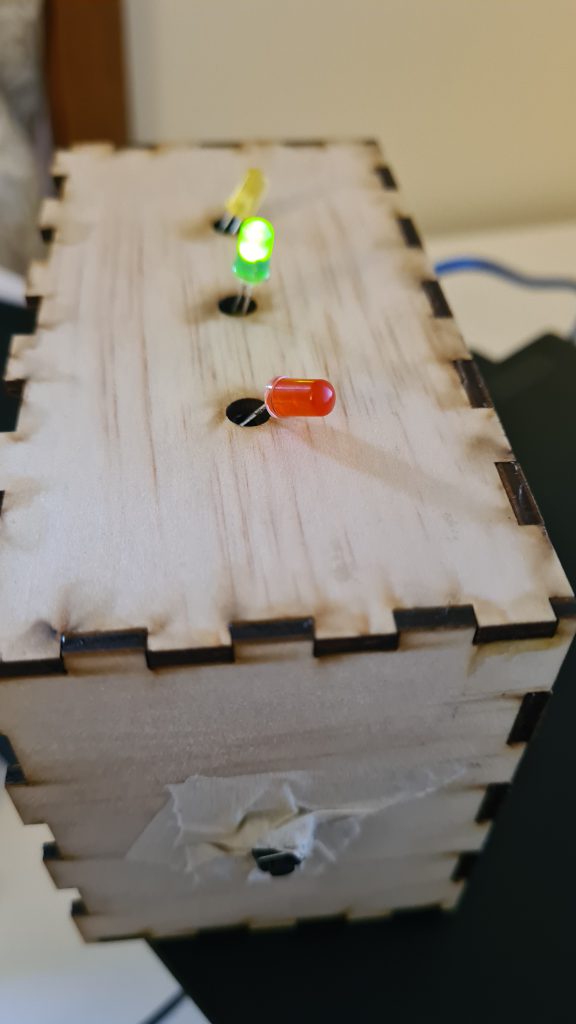

想把一个超大的图片切成九宫格,找了一圈,多个Android app都是纯广告软件,每一步操作都是广告,最关键是处理后的图片保存之后不是按顺序的,还有更差的app完全无法保存图片。

再试了一下多个在线服务,没有一个能满足最基本的需求,非常失望。

干脆手写了个逻辑,20行代码,满足需求。

某年某司,我实现了一个核心业务逻辑,很复杂,因为尽量使用各种批处理和字典,所以跑起来还是相对比较快。

多年后,逻辑变得更复杂,性能变得很差,用户看见的就是操作超时的错误。

我接手,分析后,发现他们为了实现更多的逻辑,循环地处理每条记录,然后每条记录都多次去数据库拿不同的数据来做实现各种逻辑。

更糟糕的是,每个循环里面,还会套循环,然后每个子循环都可能会去数据库取数据然后跑复杂的业务逻辑。

最糟糕的是,每个数据库访问逻辑,都是用的ORM,而且这些ORM逻辑是没有经过优化的,而且会重复取一样的数据。

如果你遇到这种情况,你会:

A. 排查性能最差的那个逻辑,然后就优化那个逻辑(但是需要考虑积少成多,记录数多了,每条加起来的总时间也会很长)

B. 重写整个逻辑

我一般是按照给定的交付时间来决定。如果时间/成本允许,我会选择重写。否则,只能先做性能分析,找到最慢的那几个逻辑,然后改造。

鉴于时间等资源有限,没有采用重写,而是尽量使用批处理。经过优化,现在的速度提升了18倍。

主要优化手段是把需要使用的数据库记录都预加载,然后传递到每个循环中,大大减少了频繁细小的数据库操作。

GitHub的markdown支持mermaid.js,直接把你在md里的mermaid代码利用iframe渲染为可交互的各种类型的图表(譬如流程图等等)。相关支持可以看看GitHub官方博客:Include diagrams in your Markdown files with Mermaid – The GitHub Blog

Mermaid.js的功能挺多的,可以访问 Tutorials | Mermaid 来查看其如何支持:

当然,GitHub支持多种图表渲染方式,mermaid.js是其支持的其中一种。你还可以使用GeoJSON等来渲染地图,STL来做三维建模,等等。

详细使用方式,可以访问Creating diagrams – GitHub Docs查看。

类似的产品,还有plantuml (https://plantuml.com),其功能不错,不过在GitHub这个场景,不被其md支持。

另外说一个误区:相比HTML的复杂markup,我们可能以为追求简洁的markdown不支持html。其实我们完全可以在markdown里面写基本的html。

譬如,在表格的某个cell里面,我们可以签入<ul><li>这种标签来做简单的列表。

不同的业务数据的删除需要不同的策略,一些需要永久保留,一些可以直接删除。

关系型数据库里面,一条记录的删除,根据业务需要,很大可能选择软删除,因为:

因为删除一条被外键引用的数据,数据库系统会遍历相关数据,确保没有被引用才删除,所以有可能很慢,譬如用户表,一般会被大量业务表引用,物理删除用户可能会超时。

举个具体例子,一个商城,如果下架一个商品,不会做物理删除,因为所有历史订单、收据、报表等等都要层级删除,那严重破坏数据完整性。

又或者员工不爽,离职了,如果物理删除这个员工的记录,那所有和ta相关的数据都要被删除,那是不合理的。

所以这里,很多时候,不是做“删除”,而是做状态改变,所以我们称之为“软删除”。

另外,总会有手贱/失误的时候,如果要让DBA去找历史数据回来修复,那系统功能受影响的时间就受限于DBA了。

另外,关于数据有效性问题,历史数据未必是最新的,老数据一些时候比没有数据更糟糕。

软删除是后悔药,大大降低了损失的可能性。毕竟,你永远不知道哪天你又需要那条被删除的记录了。

当然,这样会带来几个问题。首先是有效数据的过滤问题。譬如现有的的用户列表逻辑,需要去掉被标记为删除的数据。这种情况,要么做个视图,要么逻辑加入过滤条件。

如果对标记字段(譬如IsDeleted: bool 或者Status: int),一般没有很好的entropy,所以不是很好的候选索引字段,但是我们可以做筛选索引(filtered idnex)来解决。

另外,需要考虑唯一主键,因为之前同一个业务只有一条记录,现在可以有多条(1条有效,n条被删除)。譬如用户表,软删除了用户Foo,那以后注册的用户就不能用Foo这个名字了。这种数据冲突比较麻烦,所以这样会对业务逻辑增加难度。

还有,数据不被物理删除,随着时间推移,会累积越来越多的数据,这个可能会带来几个问题:

有些公司有一定的流程,专人对被标记擅长的数据进行审查,确认这个数据是否真的应该被删除。

其次,可以实现一个定时服务,在系统空闲的时候,删除那些被标记了的数据。

除了现有表做标记的软删除,其他做法如不原表留下,转到历史表,不过这种情况下外键约束就有层级关联问题要解决了,除非完全不用外键约束。

当然,除了历史表,还可以写到其它数据存储结构,譬如NoSQL等。

如果不写定时服务,可以考虑即时的表删除触发器,一般关系型数据库系统提供这个功能,当一条记录被删除的时候,会调用你定义的删除触发器逻辑,在这个触发器里面,你根据业务需求做各种操作,譬如把数据挪到历史表等。

视乎具体业务需求和合规性要求,被标记软删除的数据,保留时间可以从1天到永久都有可能。

非关系型数据库天生没有这种强约束的优势/烦恼,可以直接物理删除。

数据的保护和加密会在另外一篇文章详细讨论。

即便物理删除,我们也需要考虑,如欧盟的GDPR和一些国家的Privacy Act要求之前的数据备份也是需要删除的,这就对冷备份的数据有挑战了。

总而言之,不同的公司不同的业务应该有不同的删除/保留/备份/安全策略,不能一概而论。数据管理的最终目标:

性能重要,但不是最重要的。关于性能,我对后端、数据库、云、整体架构有多年的实战经验,有兴趣的同学可以扫描右边二维码加我讨论。

所有文章内容版权所有,任何形式的转发/使用都必须先征得本站书面同意。本站保留一切追究的权利。

王四哥最近发的热点微博 https://www.weibo.com/6719268224/IcAby5Jwk ,大意就是大部分博客内容不堪入目,所以大家还是没折腾了。

我对这个不吐不快。

我之前写过一篇《.NET的前世、今生与将来》,在微信群发,一个技术群里有人说(大意):不是大牛就别写这样的文章了。我当时就怼(大意):“这样是扼杀技术发展”。因为.NET的生态在中国很差(起码在过去10多年里),我希望通过这篇文章让大家认识到不能刻舟求剑,.NET不再是你们想象中那样的只能在Windows上跑(各个操作平台都可以跑了),更加不是收费的(从第一天开始就是免费的),而且是全面开源了。

至今,我没有看见一篇文章能企及我这个文章的广度的。

一些网站,和一些大V,有利益关系,互相推文章。其中一些文章,简单的翻译或者片言只字,被追捧着高呼:真香。

自己解决不了问题,我们会搜索方案。网上确实充斥着质量参差不齐的资源,如果我们无法分别这到底是否适合我们的问题,那我们很大可能会掉坑里。譬如Stack Overflow,一些被标注为答案的,并不是最佳答案,甚至不是正确答案。

学习是有成本的,不仅仅是主动学习的过程需要时间和精力,做到深处,我们还需要为各种坑埋单。

所以,四哥的观点,我是理解的。

喜欢英语和在澳洲工作近10年,让我养成了看英文技术文章的习惯。很多时候,技术文档我是直接看的英文官网而不是翻译,因为翻译过程中可能出现的偏差会导致我折腾时间。

但是,我对国人的英文水平深有理解,所以,不够是翻译还是把英文文档看完理解后重新演绎(编著),都是可以理解的。

原博说的那位老师,他的文章我看了不少。他擅长对各种技术文章阅读理解后编著,这个我没有问题,支持推进技术的发展。譬如他写的数据库表连接各种情况(左右/内/全),传统文章都是用Venn diagram(维恩图),基本上就是2个圈圈,部分/完全的空心或实心相交。他的文章指出,可以用不同颜色的行列数据更加直观地表达数据关系。他是看了英文技术原文然后把原文的图片搬过来,然后部分内容重新组织了。其他文章有类似的情况。我每天保持阅读大量技术文章的习惯,看多了,就知道了。

技术是一个累加的过程。不同的人有不同的水平。不管文章写得多差,总会有读者获益。不能因为水平不够高,就不能、不应该写文章。不管是为了个人总结还是让新手入门。当然,我相信搞技术的,误人子弟不是写文章的初衷,我们能做的,就是写之前尽量多查一下官网原文。写出来后,读者的阅读本身就是一个勘误的过程。

当然,跟四哥说的那样,很多人都是“码了后看”,然后就太监了。之前看见一个说法,互联网上,90%的人只看9%的人评论1%的人写内容。这个比较接近80/20法则。

能在某个领域有非常深的造诣,成为专家,那是属于少数。如果能在多个领域都成为专家,那是凤毛麟角。如果你告诉我某个人在所有技术领域都是专家,我觉得那是独角兽。

譬如,技术专家Z在Linux、分布式有非常深的行业经验,阅读了大量技术文档,总结出来写了一系列文章,这个我购买过并且细读了相当一部分的,质量是不错的,其他部分我粗略地看了因为我之前掌握了。

但是,对.NET、SQL Server、Azure等方面的技术,有不少技术专家写了不少优秀的文章。这个不是旗帜鲜明地反微软技术的专家会去写的。那你有什么理由不让别人去写这块的内容?

不同的水平看同一个事物有不同的理解。多年前我对数据库没有理解,那些窗口函数/行列变换让我抓狂。多年后,我对烂代码各种吐槽,因为我每天要给这些代码擦屁股。段位高了,自然很多事情都不入法眼,甚至嗤之以鼻。但这并不代表别人不能够和不应该继续修炼。

网上各种鸡汤,贩卖焦虑,譬如大龄码农被辞退、找不到工作、甚至跳楼之类的新闻,或多或少让大家不安。我反复强调过我对老油条的各种不满,学习应该是终身的,否则后辈追赶上来甚至超车,你要给年轻人汇报,心态难以端正。

所以,我的意思是:很大事情要分两面看,不要搞技术一言堂。大家都应该去写文章,目标是不断学习和提高技术,让文章质量越来越高。

如果别人让你别出声,让他们闭嘴和滚蛋。

所有文章内容版权所有,任何形式的转发/使用都必须先征得本站书面同意。本站保留一切追究的权利。

Object Relational Mapping,对象关系映射,一般简写为O/RM,或者更常见的ORM,就是数据库里面的一条记录,映射到一个对象,记录里面的字段,成为对象的属性。这是面向对象的数据访问方式。

在没有O/RM之前,我们习惯使用代码生成器来根据表结构自动生成各种CRUD(增删查改)方法。但是,这只能满足简单的操作,当业务复杂起来,特别是关系型数据,这个方法捉襟见肘。

不同的技术栈有不同O/RM方案,譬如Python的SQLAlchemy、Java的JPA(Java Persistence API)这个O/RM标准接口的就有多个解决方案。.NET下有从Java的Hibernate移植过来的NHibernate、微软开源的Entity Framework(EF)、Dapper、PetaPoco等。说起Hibernate,几年前12306售票系统出现问题,说是用的Hibernate。

Jeff Atwood是计算机编程博客Coding Horror的博主。他共同创建了计算机编程问答网站Stack Overflow,并共同创建了Stack Exchange。他曾经说过“O/RM是计算机科学的越南战争”。

O/RM一个重要的特性,也是必备,就是数据库和对象之间的映射,数据库表、字段的特性,譬如字段的最大长度、各种约束(最大、最小值、默认值等)、精度、外键等,都要一一定义,不管是通过类似Hibernate的XML还是Fluent Hibernate的面向对象方式,或者一些Model-first的通过特性(attribute)来实现。

O/RM的使用,会导致两套数据库结构,一套在数据库里面,一套在O/RM定义。当你需要改动结构,你需要实现迁移,譬如改改变了字段的名字、表名。

使用O/RM的一个目的是只需要关心业务,不需要放多少时间在SQL上面,但是,学习O/RM本身是需要时间的,而且,要用好O/RM,不可避免要学好SQL,所以这个学习时间可能是单纯学习SQL的两倍或者更多。

之前说生产力是O/RM的优势,但是这个是建里在你必须先把映射关系建立好的基础之上,这个过程视乎业务系统的复杂度,需时可能比较长

数据库的表结构很多时候无法和对象模型完整一致,导致了在使用过程中需要做手工的转换,模型也随之快速增大,增加了逻辑的复杂性

之前说O/RM可以切换数据库系统,但是当你把一个数据库系统真的用起来之后,你会发现,你很大机会需要用到数据库系统的一些特性,这是其它数据库系统没有的,那么,这个迁移将会很大的挑战性。越抽象,复杂度越高,成本也随着增加

如果你希望深入了解数据库访问、O/RM最佳实践,跟随有15年+经验的数据库专家手把手、全程实战、系统性地、快速学习和提高数据库开发技术,欢迎访问 DevYeah.com联系我们。

本文完整版本在Dev Yeah的交互式学习平台上,有兴趣的同学可以点击这里免费注册,马上免费试用Dev Yeah的各种技术教学视频!

Dev Yeah推出全新服务:每日技术精选。

不同的技术人有不同的阅读/学习习惯,一些一天读几篇甚至多篇文章,但是:

Dev Yeah的每日技术精选,包括但不限于:业界新闻、新/优秀开源项目、优秀技术文章等。分类包括前端、后端、数据存储、安全、AI/大数据等

每天我们会重点对其中一篇内容进行精读概述,让大家能够更好地理解、掌握和提高技术水平。

点击这里免费注册,马上免费试用Dev Yeah的每日技术精选!

要系统、快速、全面提高您的技术水平吗?访问Dev Yeah了解我们提供的全栈(前端、后端、数据存储和必备等)和Python数据科学课程!15+年全栈开发经验(Web前端、后端、数据库、必备等)的技术专家手把手、全程实战!

扫描下面的二维码加入Dev Yeah技术交流群

扫描下面的二维码联系Dev Yeah客服

所有文章内容版权所有,任何形式的转发/使用都必须先征得本站书面同意。本站保留一切追究的权利。

是否想系统性地学习和提高Web前端、后台和数据库等技术栈的水平和能力?想成为能力出众的全栈开发人员?希望了解Python、数据科学和分析?在掌握的技术之外,渴望学习一门新的语言/技术,譬如Clojure、Docker/kubernetes容器、AWS/Azure云平台开发? https://www.devyeah.com/

是否希望免费注册、免费试用相关课程?扫描二维码加入Dev Yeah学员群便获得!访问 https://www.devyeah.com/ 扫描页面最下面的二维码加入技术群,和各位小伙伴分享、学习和提高技术!

我们通过在线互动直播、线下手把手培训和随时随地的视频回放3种方式为你提供全方位的贴心教学服务。

全程动手实战,提供最佳实践指导,在较短时间内全面提升你的技术深度、广度和自我学习能力,累计项目经验、充实履历,助你获得更好的工作机会,成长为优秀的全栈/数据科学工程师 https://www.devyeah.com/

免费注册和获取《Dev Yeah每日技术精选》:

https://www.devyeah.com/ile

Dev Yeah技术群

Dev Yeah客服

系统运行过程中,或多或少会产生不同级别的日志:详情、普通、严重、错误等。一般越严重/重要的,产生的数量越少,反之,越多。

在开发环境中,我们一般会启用最详细的级别,这样可以全程跟踪系统运行情况,在生产环境中,我们一般只打开严重/错误级别,因为这样才是我们感兴趣的。但是,但真的遇到严重问题的时候,我们不能定位具体问题,就可能要打开更详细的级别来辅助我们找到问题的根源。

一些公司仍然把所有日志写入文本文件,譬如Windows的IIS网络服务器的日志就是用的CSV格式。

稍好一点做法,是数据库表。但是日志数量不断增加,这些数据都存放在一个表里面,迟早也会遇到需要切分的问题,而且一般数据库的成本比磁盘文件要高,所以一般来说,生成环境只记录最关心的内容。

而且,因为日志有一个天生的特点,就是每天记录的产生都有一个时间戳,而且是随着时间变化不断变大。我们做查询的时候,一般是按照时间来排序,最常见的就是倒序,也就是最新的日志,我们最感兴趣。所以,日志在数据库中的存储,一般是按时间戳做聚集倒序索引。

当然还有更特别的,就是遇到严重/异常的时候,通过邮件发送,甚至短信通知运维。

一般是按每天来切分存储,如果数据量很大,那颗粒度会更低,譬如每个小时等。也有按大小来切分的,譬如每10M生成一个文件。这些都是所谓的窗口大小,可以按时间、大小、地区、部门等等来切分。

日志的记录,除了排除,我们来会用来做数据统计。

然而从不同纬度分析这些数据麻烦,譬如分布式系统哪个地方的哪个模块那些用户群只有特定问题等,而且一般不能实时。

Raygun.io这个云日志服务提供商满足以上需求,他们以前用的nodejs,后来改成asp.net core,性能提升了20倍。

是否想掌握怎样实现搞性能的分布式系统开发和设计出高效的日志系统?

可以找我们Dev Yeah学习全栈课程!访问官网 DevYeah.com 帮助你快速成长为更优秀的软件工程师!

所有文章内容版权所有,任何形式的转发/使用都必须先征得本站书面同意。本站保留一切追究的权利。

不购买正版,在中国,是个常态,不管是知识产权,还是各种假冒伪劣山寨产品。而且这种行为,自然而然,大部分盗版使用者都不以为是。

譬如,在网上看见一本著名的收费书籍,搜索一下,直接下载pdf文件或者其它电子书格式,一下子省了几十块了。

更有甚者,把这些盗版传播,甚至转手卖钱。相信各位作者都对这些行为非常反感。

这些从事创建发明行业的开发人员,自己不尊重别人的劳动成果,还能指望别人尊重自己的产品吗?换位思考一下,是否希望别人尊重自己的劳动果实,是不?

因为习惯了免费东西,一听说某种产品/服务要收费,一些开发人员会找出各种不愿意付费的理由:

如果每个消费者都抱着这种心态,那会扼杀创新,阻碍技术的发展。

一些开发人员加入某个付费服务的技术群,看见服务提供商发产品的相关介绍,直接扔一句:”全是广告,退群了”。

我想问3个问题:

举个简单例子:你花了相当的时间和精力研究出来的东西,有一定的经济价值,陌生人一上来就说:你要把这个免费公开,让我来享受一下。你的实际行动会是什么?

如果你觉得别人提供的服务没有价值,不值得花钱,请你自己慢慢学习钻研,看看你需要花多少时间和精力才能掌握你需要的技术和达到你希望的水平。

或许,你会觉得,我还年轻,有的是时间,反正我也不大着急。

然而,最佳时机是10年前,其次是现在。合适的服务,可以帮助你快速掌握和提高技术水平, 让你在相对较短的时间内获得最大的收益。

相当部分开发人员是伸手党,要么微博私信,要么微信加了好友,直接问技术问题,基本礼貌都没有。而且部分还是连问问题都不会的,譬如:

换位思考一下吧。如果你被别人问这种问题,你怎么回答?如果不能,那你为什么那样提问?

部分开发人员没有系统地学过软件开发,也没有很好的学习能力,连研究技术问题的能力都是比较弱的,譬如搜索,一般是搬运stackoverflow的答案,然而,一些SO的答案并不是最佳答案,部分连答案都不是正确的答案。

学习能力,不仅仅是钻研具体函数怎么实现/调用的能力,更多是思考能力。

今天在微博看见一个观点,大概意思软件开发人员发展路线分几个阶段:

那些被宠坏的开发人员,往往在第一级挣扎。

对内容的正确与否、质量高低、适用性的判断能力也很重要。

一些开发人员把对掌握某种技术说需要的时间和精力看得比较简单,以为根据一些关键字搜索出几篇文章,然后奉为真理,应用到产品中便可。

一般是掉到坑里,挣扎好久,爬出来了 ,这是相当可怕的 。希望他们能吃一堑长一智。

首先,先看看你自己是否符合技术范围、水平、工作合规性(签证等)等要求,再问问工作要求细节,最后问工资也不迟。

我遇到过, 我发布开发人员的招聘信息 ,第一件事情是问:待遇多少钱?

给更多,欲望更大,时刻想着找下一家给更多的钱,每间公司都是踏脚石,这样不利于自己的职业生涯的发展。

有人说:“自己能力没达到,到时候面试被刷下来,继续努力呗”,但这完全是浪费双方的时间。

合适的工作环境和有挑战的内容,才有助于你的职业生涯的发展,这些才应该是你注重的地方。

而且,面试是双向的,如果你只问工资,人家只问你年龄,你觉得靠谱吗?

一个网上的博客文章,是一个从事软件开发的学生,写的总结报告,里面有一句话:“我的疑问是既然我们是一个团队,有领导带领,那我们为什么要和领导承担同样的压力和责任,如果说我们是创业团队,大家用敏捷流程无疑会是不错的选择,但是既然是在公司,既然有领导,他领的工资还比我多,那我们又应该从哪儿去寻求动力与激情去承担这些责任呢?”

一般开发团队有各自的分工,但很多时候一个开发人员需求分析、设计、开发、测试、写文档、发布、运维、装电脑等都得做,这些活(压力/责任)你可以不去做,但是总得有人去做,也总会有别人去做(你失业了)。

而且,责任多,是好事,你有了更多的学习机会。趁年轻,多学习,不要怕吃亏吃苦。

你希望做一个小小的螺丝钉,还是希望能发挥所长,做出成绩,产生更大的影响,这是你的选择权。

你需要知道的是你的职业生涯目标,3-5年后,你会成为怎样的开发人员,这些你能决定的,你不去承担工作范围内合理的压力和责任,那很大可能多年后,你还是会碌碌无为。

而且,合格的领导,他们拿比你高的工资,原因很多,譬如:

互联网每时每刻都在产生大量的技术资源,我们面对这样海量的信息无所适从:

1. 究竟学哪些新技术?

2. 究竟哪些资源质量高?

3. 究竟我们怎样才会不走弯路?

4. 究竟最低成本的学习办法是什么?

5. 究竟我怎样才能用最短的时间提升自己的技术深度和广度?

6. 究竟我怎样才能用最快的速度提升自身价值?

如果你觉得自己的时间不值钱,那当然可以慢慢消耗时光。然而,对大部分人来说,最值钱的,是时间,而且这个数字在不断减少,而且速度惊人。

拿22岁毕业,60岁退休来说,你的工作人生只有短短的13870天。没错,就13870天!如果一周按5天算,那只有9907天,1万天都不够。

那么,你是否愿意投入一些时间、花一些钱去学付费服务,快速提高技术水平,从而能加薪升职、找到更好的工作呢?

所有文章内容版权所有,任何形式的转发/使用都必须先征得本站书面同意。本站保留一切追究的权利。